Come Trasformare la Vostra Knowledge Base in un Agente IA Interno Sicuro e Protetto

Nel panorama aziendale odierno, la conoscenza organizzativa rappresenta il vero vantaggio competitivo. Tuttavia, secondo ricerche di Deloitte, il 94% delle aziende non dispone di processi formali per valorizzare questi asset intangibili.

Questo studio analizza come le tecnologie RAG (Retrieval-Augmented Generation), GraphRAG e Knowledge Graph possano trasformare la vostra knowledge base aziendale in un agente intelligente sicuro, proteggendo la “Coscienza Aziendale” e generando un ROI misurabile.

Risultati chiave:

- Il mercato globale RAG crescerà da $1,3 miliardi (2024) a $74,5 miliardi entro il 2034 (CAGR 49,9%)

- Implementazioni di successo documentano ROI del 320% in tre anni

- Le aziende riducono i tempi di sviluppo di applicazioni analitiche del 3x

- I knowledge graph aziendali raggiungono una crescita di mercato del 36,6% CAGR fino al 2030

Il Problema: Il Gap della Conoscenza Aziendale

La Frammentazione Informativa

Le organizzazioni moderne affrontano una sfida critica: la conoscenza è dispersa in silos disconnessi. Dati sui clienti risiedono in Salesforce, informazioni sui prodotti in SAP, documentazione tecnica in SharePoint, conversazioni strategiche in Slack e spesso nella conoscenza delle persone.

Questa frammentazione genera inefficienze operative misurabili.

I modelli linguistici di grandi dimensioni (LLM) standard, pur offrendo capacità generative avanzate, sono limitati alle informazioni disponibili durante il loro addestramento, risultando insufficienti in ambienti che richiedono conoscenze specifiche e sfumate dell’azienda.

Il Costo dell’Ignoranza Organizzativa

Ricerche IBM evidenziano che le iniziative AI aziendali raggiungono attualmente un ROI medio di appena il 5,9%, principalmente a causa della mancanza di fondamenta solide di conoscenza organizzativa. Senza accesso strutturato alla conoscenza interna, anche i sistemi AI più avanzati generano:

- Allucinazioni: risposte inventate basate su pattern probabilistici

- Risposte generiche: prive di contesto aziendale specifico

- Mancanza di tracciabilità: impossibilità di verificare le fonti

- Compliance risk: violazioni potenziali di policy aziendali

La Soluzione: Retrieval-Augmented Generation (RAG)

Cos’è la Tecnologia RAG

Il Retrieval-Augmented Generation (RAG) è un processo applicato ai modelli linguistici di grandi dimensioni per rendere i loro output più rilevanti in contesti specifici, permettendo agli LLM di accedere e fare riferimento a informazioni esterne ai loro dati di addestramento, come la knowledge base specifica dell’organizzazione, prima di generare una risposta con citazioni incluse.

Architettura RAG: Le Due Fasi Fondamentali

Il RAG opera attraverso due fasi distinte:

Fase 1: Ingestion (Indicizzazione) Simile a rifornire gli scaffali di una biblioteca e creare un indice dei contenuti, questa fase permette a un bibliotecario di localizzare rapidamente qualsiasi libro nella collezione. Durante questo processo:

- I documenti vengono suddivisi in “chunk” (frammenti)

- Vengono generate rappresentazioni vettoriali dense (embeddings)

- Si crea un database vettoriale interrogabile

Fase 2: Retrieval (Recupero) Durante una query dell’utente:

- Il sistema recupera i documenti o passaggi più rilevanti

- Questi vengono forniti come contesto al modello generativo

- Il modello produce una risposta basata esclusivamente su queste fonti verificate

Vantaggi Strategici del RAG

A differenza dell’AI generativa alimentata da LLM pre-addestrati e fine-tuned, che generano risposte basate su dati di addestramento statici, il retrieval-augmented generation ancora le risposte in informazioni proprietarie, curate e in tempo reale.

Vantaggi operativi documentati:

- Aggiornabilità continua: I sistemi RAG integrano informazioni aggiornate da fonti dati senza necessità di riaddestramento, garantendo che gli output AI siano sempre current

- Scalabilità intrinseca: Recuperando solo i dati più pertinenti per una query specifica, si riduce il carico computazionale

- Costi di manutenzione ridotti: Non richiede riaddestramento periodico come i modelli fine-tuned

- Tracciabilità completa: Ogni risposta include riferimenti alle fonti originali

L’Evoluzione: GraphRAG e Knowledge Graphs

I Limiti del RAG Tradizionale

I sistemi RAG di base si affidano esclusivamente alla ricerca semantica nei database vettoriali per recuperare e classificare insiemi di frammenti di testo isolati. Mentre questo approccio può individuare alcune informazioni rilevanti, non riesce a catturare il contesto che collega questi frammenti.

Di conseguenza, i sistemi RAG basilari faticano a rispondere a domande complesse multi-hop che richiedono correlazioni tra diverse fonti informative.

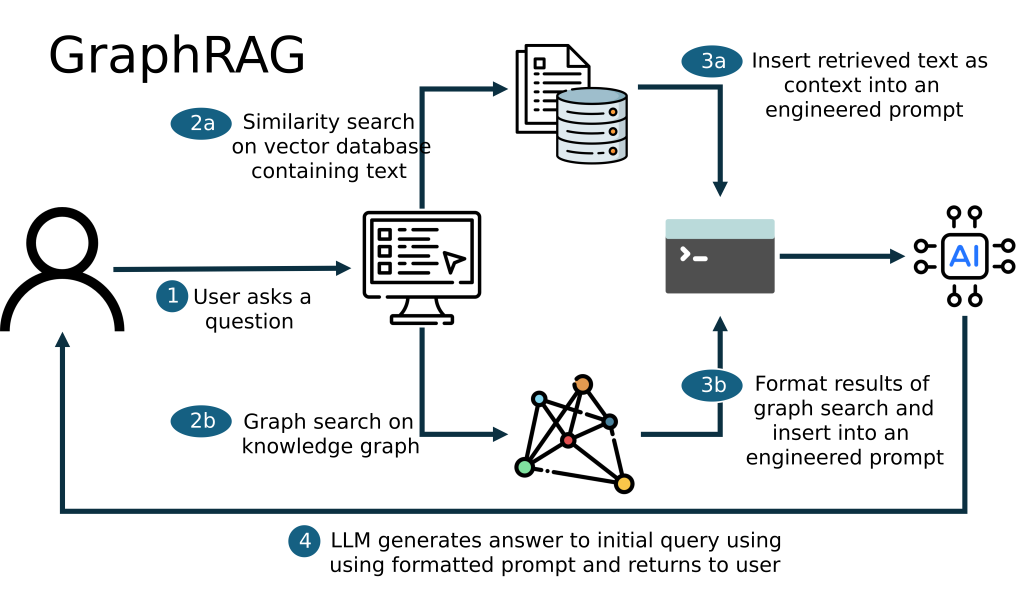

GraphRAG: Il Salto Qualitativo

GraphRAG è una versione avanzata del retrieval-augmented generation che incorpora dati strutturati come i “grafi”, in particolare knowledge graph. A differenza dei sistemi RAG basilari che si affidano alla ricerca vettoriale per recuperare testo semanticamente simile, GraphRAG sfrutta la struttura relazionale dei grafi per recuperare e processare informazioni basate su query specifiche del dominio.

Secondo uno studio pubblicato da Microsoft Research, GraphRAG ha richiesto fino al 97% in meno di token pur fornendo risposte più complete rispetto al RAG standard.

Architettura dei Knowledge Graphs Aziendali

I knowledge graph rappresentano informazioni come rete di nodi (entità) e archi (relazioni). Il modello a grafo consente uno storage, gestione, interrogazione e processamento efficienti della ricchezza delle informazioni del mondo reale.

Casi d’uso aziendali comprovati:

- Unificazione semantica: I knowledge graph agiscono come layer di overlay semantico che connette i silos dati senza richiedere spostamenti fisici dei dati

- Ragionamento contestuale: Abilitano query come “Quali clienti impattati dall’Interruzione di Servizio (ServiceNow) hanno rinnovi nei prossimi 30 giorni (Salesforce)?”—domande quasi impossibili da rispondere in tempo reale con SQL tradizionale

- Esplainability: Con relazioni esplicitamente definite, i knowledge graph aumentano trasparenza e fiducia permettendo al sistema RAG di tracciare il percorso verso le risposte

Sicurezza, Compliance e Governance

Il Framework Zero Trust per l’AI Aziendale

Lo Zero Trust tradizionale opera sotto l’assunzione di diffidenza universale. I suoi principi di sicurezza necessitano di adattamento perché gli attacchi moderni potenziati da AI, combinati con ambienti cloud rapidi, rendono i metodi tradizionali insufficienti.

Principi Zero Trust 2.0 per RAG:

- Autenticazione continua: Verifica costante di utenti e dispositivi

- Micro-segmentazione: Limitazione dei movimenti laterali nelle reti

- Least privilege access: Riduzione dell’esposizione al minimo necessario

- AI-augmented monitoring: Sistemi di machine learning che monitorano attività in tempo reale

Conformità GDPR e Gestione dei Dati Personali

Per le aziende europee e quelle che trattano dati di residenti EU, la conformità GDPR è non negoziabile. La non conformità al GDPR può risultare in multe significative fino a €20 milioni o 4% del fatturato globale, a seconda di quale cifra sia maggiore.

Requisiti tecnici per RAG GDPR-compliant:

- Controlli di accesso a livello documento: Non copiare tutti i documenti in un indice piatto senza controlli d’accesso. Applicare controlli di accesso a livello documento durante il retrieval

- Isolamento multi-tenant: Essenziale nei database vettoriali per scenari multi-tenant

- Data Protection Impact Assessment (DPIA): Obbligatorio dove il processing è probabilmente ad alto rischio

- Principi GDPR: Legalità, limitazione dello scopo, minimizzazione dei dati, accuratezza, limitazione dello storage, integrità e confidenzialità

EU AI Act e Governance AI

L’EU AI Act è entrato in vigore nel 2024, con obblighi scaglionati fino al 2026-2027. Iniziare ora a mappare i casi d’uso, le categorie di rischio e la documentazione tecnica.

Azioni concrete:

- Allineamento con ISO/IEC 42001 (sistemi di gestione AI)

- Categorizzazione dei sistemi RAG per livello di rischio

- Documentazione di trasparenza algoritmica

- Processi di audit regolari

ROI e Business Case

Metriche Finanziarie Dirette

Le implementazioni RAG enterprise documentano ritorni economici misurabili:

Case Study: Stardog Enterprise Knowledge Graph Platform Uno studio Total Economic Impact (TEI) di Forrester Consulting sulla piattaforma Stardog ha rivelato un ROI del 320% in tre anni. Lo studio ha evidenziato che le organizzazioni hanno ottenuto $9,86 milioni in benefici totali, principalmente guidati dall’evitare costi infrastrutturali e accelerare i risultati di data science.

Velocità di sviluppo: I team di sviluppo hanno riportato la costruzione di applicazioni di data analytics 3 volte più velocemente, una metrica critica in ambienti aziendali agili.

Risparmio Operativo Documentato

Riduzione tempi di ricerca: In uno studio su un’azienda IT globale con oltre 300 agenti di supporto, l’implementazione di un RAG-powered Enterprise Knowledge Assistant ha ridotto i tempi di ricerca da 8-10 minuti per ticket a pochi secondi, generando risparmi annuali stimati in centinaia di migliaia di euro.

Ottimizzazione onboarding: Ridurre l’onboarding da 90 giorni a 60 giorni può far risparmiare migliaia di euro, liberando tempo sia per il team HR che per i dipendenti in formazione.

Calcolo del ROI: Framework Pratico

Formula ROI per Knowledge Base AI:

[ ROI (%) = [(Benefici Netti - Investimenti KM) / Investimenti KM] × 100 ]Componenti dei benefici misurabili:

- Riduzione costi personale supporto: Ore risparmiate traducibili in risparmi FTE

- Riduzione errori manuali: Stima del costo evitato

- Diminuzione ore onboarding/formazione: Calcolo riduzioni costi associate

- Miglioramento First Contact Resolution (FCR): Riduzione follow-up

- Aumento Customer Satisfaction (CSAT): Correlazione con retention

- Opportunità upselling: Cross-selling durante interazioni

ROI tipici documentati: Un ritorno sull’investimento del 20-30% è generalmente considerato ragionevole, anche se questo può differire in base al settore e agli obiettivi aziendali.

Benefici Strategici Non Tangibili

Oltre ai ritorni finanziari diretti, i sistemi RAG enterprise generano valore attraverso:

- Preservazione della conoscenza istituzionale: Evita perdita di know-how con il turnover

- Accelerazione decision-making: Accesso istantaneo a insights storici

- Innovazione abilitata: Correlazioni cross-funzionali prima invisibili

- Vantaggio competitivo: Risposta più rapida alle dinamiche di mercato

Workflow Automation: dove l’IA genera realmente valore

La maggior parte del valore dell’IA arriva non dalla risposta del modello, ma dalla capacità di automatizzare workflow reali. Alcuni esempi:

- triage intelligente delle e-mail;

- classificazione documentale;

- estrazione dati da allegati e routing;

- controlli automatici di coerenza;

- workflow multi-agente in settori come alimentare, sanitario, legale.

Strumenti come n8n permettono di connettere e orchestrare questi elementi, creando processi IA robusti e tracciabili.

Roadmap di Implementazione

Fase 1: Assessment e Strategia (1-2 mesi)

Obiettivi:

- Audit delle fonti dati esistenti

- Identificazione use case prioritari

- Valutazione maturità organizzativa AI

- Definizione KPI e metriche successo

Deliverable:

- Inventario knowledge assets

- Business case con proiezioni ROI

- Architettura tecnica preliminare

- Piano di change management

Fase 2: Proof of Concept (2-3 mesi)

Attività:

- Implementazione pilota su caso d’uso specifico

- Integrazione con 2-3 fonti dati critiche

- Test utente con gruppo limitato

- Validazione metriche baseline

Tecnologie consigliate:

- Piattaforme RAG enterprise: AIDOCS, Azure AI Search, AWS Kendra, Google Vertex AI

- Database vettoriali: Pinecone, Weaviate, Milvus

- Framework GraphRAG: Neo4j, Microsoft GraphRAG, Stardog

Fase 3: Produzione e Scale (3-6 mesi)

Espansione:

- Rollout graduale per dipartimenti

- Integrazione fonti dati aggiuntive

- Implementazione governance e controlli accesso

- Formazione utenti finale

Monitoraggio continuo:

- Dashboard analytics utilizzo

- Tracking KPI ROI

- Feedback loop qualità risposte

- Aggiornamento modelli e embeddings

Fase 4: Ottimizzazione e Governance (Ongoing)

Manutenzione:

- Refresh periodico knowledge base

- Retraining embeddings con nuovi dati

- Audit conformità GDPR/AI Act

- Espansione casi d’uso

Best Practices e Raccomandazioni

Le aziende che raggiungono risultati concreti sono quelle che affrontano la trasformazione IA partendo da una valutazione strutturata della propria maturità.

- Data Readiness: qualità e accessibilità dei dati

- Knowledge Maturity: livello di formalizzazione della documentazione

- Process Readiness: chiarezza dei flussi operativi

- Automation Feasibility: presenza di task ripetitivi e standardizzabili

- Security & Compliance: gestione dei dati sensibili e regolamentazione

- Organisational Capability: competenze interne e sponsorship

Case study essenziali (reali, anonimizzati)

Fattori Critici di Successo

1. Qualità dei dati: La qualità del RAG dipende da come si prepara il contenuto per il retrieval. Durante l’indicizzazione, utilizzare il chunking per suddividere documenti di grandi dimensioni in modo che porzioni possano essere abbinate indipendentemente.

2. Approccio hybrid search: Per garantire i risultati più rilevanti per l’implementazione RAG, utilizzare query ibride che combinano ricerca per parole chiave (non-vettoriale) e ricerca vettoriale per massimizzare il recall.

3. Executive sponsorship: Assicurare buy-in C-level attraverso business case quantificabili e alignment strategico

4. Change management strutturato: Investire 15-20% in più upfront in governance e training genera 40-60% di ritorni maggiori

Errori da Evitare

- Over-engineering iniziale: Partire con MVP focalizzato su use case specifico

- Sottovalutare data governance: Implementare controlli accesso fin dall’inizio

- Ignorare l’esperienza utente: Design interfacce intuitive per adozione

- Mancanza di metriche: Definire KPI chiari prima dell’implementazione

- Vendor lock-in: Preferire architetture LLM-agnostic per flessibilità futura

Selezione Vendor: Criteri Chiave

Valutazione piattaforme RAG:

- Supporto multi-sorgente (cloud, on-premise, hybrid)

- Capacità GraphRAG native o integrabile

- Compliance GDPR/ISO certificata

- Scalabilità documentata (volumi dati, utenti concorrenti)

- Opzioni di deployment (SaaS, private cloud, on-premise)

- Ecosistema integrazioni con stack tecnologico esistente

Trend e Prospettive Future

Evoluzione Tecnologica

RAG Multimodale: Il RAG multimodale includerà una varietà di formati dati, come audio, video e immagini, nei sistemi alimentati da AI, aggiungendo recupero di immagini, conversione speech-to-text e analisi video alle pipeline di retrieval.

Real-time RAG: Integrando feed di dati in tempo reale nei modelli RAG, i sistemi AI saranno in grado di recuperare dinamicamente le informazioni più recenti, garantendo che le soluzioni AI generative forniscano materiale preciso e contestualmente appropriato.

Agentic RAG: Sistemi che combinano RAG con capacità di reasoning e orchestrazione multi-step per workflows complessi

Previsioni di Mercato

Le piattaforme RAG diventeranno de facto nell’approccio al DIY. Le aziende hanno realizzato i costi e i rischi associati al percorso DIY da sole e vogliono evitare di sprecare scarse risorse assemblando da sé tutti i componenti richiesti.

Consolidamento vendor: Aspettarsi acquisizioni e partnership strategiche nel panorama RAG/GraphRAG, con focus su piattaforme integrate end-to-end.

Democratizzazione: Strumenti RAG-as-a-Service renderanno queste capacità accessibili anche a PMI con budget limitati.

Conclusioni

La trasformazione della knowledge base aziendale in un agente IA interno sicuro non è più un’opzione futuristica, ma un imperativo strategico immediato. Le organizzazioni che ritardano questa evoluzione rischiano di trovarsi con svantaggi competitivi crescenti in un panorama dove la velocità di accesso alla conoscenza interna determina l’agilità decisionale.

I Tre Pilastri del Successo

- Tecnologia appropriata: Scegliere architetture RAG/GraphRAG scalabili e sicure

- Governance solida: Implementare controlli conformi a GDPR e EU AI Act

- Cultura data-driven: Promuovere adozione attraverso change management strutturato

Passi Immediati Consigliati

Per CEO:

- Valutare la maturità attuale della gestione knowledge aziendale

- Allocare budget esplorativo per PoC RAG su caso d’uso critico

- Designare executive sponsor per iniziativa AI Knowledge

Per CTO/CIO:

- Condurre audit delle fonti dati esistenti e qualità

- Valutare vendor RAG enterprise per fit architetturale

- Definire roadmap tecnica allineata a strategia digitale

Per Innovation Manager:

- Identificare use case quick-win per PoC rapido

- Mappare stakeholder interni e resistenze al cambiamento

- Stabilire metriche successo e framework misurazione ROI

L’Opportunità è Ora

Con il mercato RAG in crescita esponenziale e casi d’uso comprovati che documentano ROI superiori al 300%, il momento per agire è adesso. Le aziende che implementano oggi sistemi di knowledge management potenziati da AI costruiscono le fondamenta per il vantaggio competitivo di domani.

La vostra “Coscienza Aziendale”—l’insieme di conoscenze, esperienze e insights accumulati—è il vostro asset più prezioso. Proteggerla, strutturarla e renderla accessibile attraverso tecnologie RAG sicure non è solo una decisione tecnologica, ma una scelta strategica che definirà la vostra capacità di innovare, decidere e competere negli anni a venire.

Riferimenti e Fonti

Questo studio è basato su ricerche e pubblicazioni di:

- McKinsey & Company: Analisi RAG e applicazioni enterprise

- Microsoft Research: Project GraphRAG e architetture avanzate

- Forrester Consulting: Total Economic Impact studies

- Gartner: Hype Cycle for Generative AI 2024

- IBM Institute for Business Value: ROI enterprise AI

- Azure AI Search Documentation: Best practices implementazione

- Neo4j: Knowledge graphs e GraphRAG

- Research and Markets: Market sizing e proiezioni

- Zscaler ThreatLabz: AI Security Report 2025

- NIST: Zero Trust Architecture frameworks

- European Commission: GDPR compliance e EU AI Act

Il presente articolo/studio è stato redatto a partire da una bozza iniziale generata mediante sistemi di Intelligenza Artificiale a supporto delle attività di ricerca e strutturazione dei contenuti. La versione finale è il risultato di un intervento umano qualificato, che ha curato la verifica critica delle informazioni, la coerenza argomentativa, l’accuratezza terminologica e il controllo delle fonti citate, al fine di garantire affidabilità, correttezza e valore informativo per il lettore.